Nous avons tous déjà vécu cette frustration : agrandir une photo pour en voir les détails, et se retrouver face à une mosaïque de pixels grossiers. Pourtant, des outils en ligne promettent aujourd’hui de transformer ces images floues en visuels nets et détaillés. Mais comment ces sites parviennent-ils à « deviner » ce qui se cache derrière les pixels ? Plongeons dans les coulisses de cette technologie fascinante.

Le problème fondamental : l’information manquante

Lorsqu’une image est pixelisée ou de basse résolution, le problème est simple à comprendre mais complexe à résoudre. Chaque pixel représente une zone de l’image, et lorsque vous agrandissez cette image, votre ordinateur doit inventer les détails intermédiaires qui n’existent pas dans les données originales.

Les méthodes classiques d’agrandissement, comme l’interpolation bilinéaire ou bicubique, se contentent de créer des transitions douces entre les pixels existants. Le résultat ? Une image plus grande, certes, mais tout aussi floue. C’est ici qu’intervient l’intelligence artificielle, qui adopte une approche radicalement différente, notamment avec ce site pour dépixeliser une image.

L’apprentissage profond au service de l’image

Les sites modernes de dépixelisation s’appuient sur des réseaux de neurones convolutifs, une forme d’intelligence artificielle particulièrement efficace pour traiter les images. Ces réseaux ont été entraînés sur des millions d’images haute résolution, apprenant à reconnaître des motifs, des textures et des structures visuelles.

Le principe est ingénieux : les développeurs prennent des images nettes, les dégradent artificiellement en réduisant leur résolution, puis entraînent le réseau de neurones à retrouver l’image originale. Au fil de milliers d’itérations, l’algorithme apprend à associer certains patterns de pixels flous avec des détails haute résolution probables.

Le processus technique : de l’upload au résultat

Lorsque vous téléchargez une image pixelisée sur un site de dépixelisation, plusieurs étapes se déroulent en coulisses. D’abord, l’image est analysée pour identifier ses caractéristiques : contraste, couleurs dominantes, type de contenu (visage, paysage, texte). Certains algorithmes détectent même les zones qui nécessitent le plus d’amélioration.

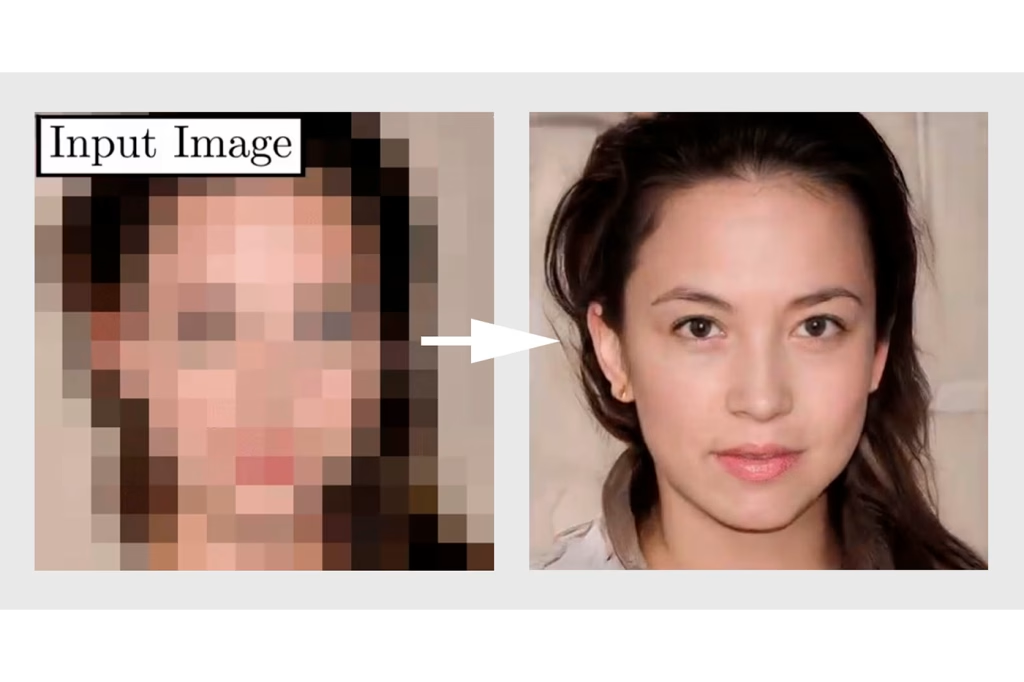

Ensuite, le réseau de neurones entre en action. Il examine l’image par petites sections, appliquant ses connaissances accumulées pour prédire les détails manquants. Pour un visage, il saura qu’une certaine configuration de pixels correspond probablement à un œil, une bouche ou des cheveux. Pour un paysage, il reconnaîtra les textures de feuillage, d’eau ou de nuages.

Le réseau utilise souvent plusieurs couches de traitement. Les premières détectent les contours et les formes générales, tandis que les couches suivantes ajoutent progressivement des détails de plus en plus fins. C’est un processus itératif qui raffine l’image étape par étape.

Les technologies sous le capot

Plusieurs architectures de réseaux de neurones sont couramment utilisées. Les réseaux ESRGAN (Enhanced Super-Resolution Generative Adversarial Networks) sont particulièrement populaires. Ils utilisent deux réseaux en compétition : l’un génère des images améliorées, l’autre tente de distinguer ces images des vraies photos haute résolution. Cette “compétition” pousse le système à produire des résultats de plus en plus réalistes.

D’autres approches, comme les réseaux de diffusion ou les transformers visuels, gagnent également en popularité. Ces technologies permettent de gérer des images de plus grande taille et de mieux préserver les détails complexes.

Les limites et défis actuels

Malgré leur efficacité impressionnante, ces outils ne font pas de miracles. Ils ne « révèlent » pas des détails cachés, mais les inventent de manière plausible basée sur leur entraînement. Si vous dépixelisez la photo floue d’une plaque d’immatriculation, le résultat pourra sembler net, mais les chiffres générés ne seront probablement pas les bons.

Les visages posent également un défi éthique. Un algorithme peut transformer un visage flou en un visage net, mais ce dernier ne sera qu’une approximation, pas la réalité. Cela soulève des questions importantes dans des contextes comme la surveillance ou l’identification.

La qualité du résultat dépend aussi fortement de l’image source. Une image extrêmement dégradée, avec très peu d’information de départ, donnera des résultats moins convaincants qu’une image simplement de résolution modeste.

L’optimisation pour le web

Pour fonctionner en ligne, ces sites doivent relever des défis techniques supplémentaires. Les modèles d’intelligence artificielle sont gourmands en ressources de calcul. Certains sites effectuent le traitement directement dans votre navigateur grâce à des technologies comme WebGL ou WebAssembly, ce qui préserve la confidentialité mais limite la puissance disponible.

D’autres envoient votre image vers des serveurs équipés de cartes graphiques puissantes (GPU) capables de traiter les calculs intensifs en quelques secondes. Ils doivent alors gérer la bande passante, la sécurité des données et le temps de réponse pour offrir une expérience utilisateur fluide.

Des techniques d’optimisation comme la quantification des modèles (réduction de la précision des calculs) ou l’élagage (suppression des connexions peu importantes du réseau) permettent d’accélérer le traitement sans trop sacrifier la qualité.

L’avenir de la dépixelisation

Les progrès continuent à un rythme soutenu. Les nouveaux modèles deviennent plus rapides, plus précis et capables de gérer des tâches plus complexes. Certains peuvent désormais restaurer de vieilles photos endommagées, coloriser des images noir et blanc tout en augmentant leur résolution, ou même transformer des vidéos entières.

L’intégration de ces technologies dans les logiciels grand public progresse également. Des applications photo sur smartphones aux éditeurs professionnels, la dépixelisation par intelligence artificielle devient un outil standard plutôt qu’une curiosité technique.

Conclusion

Les sites de dépixelisation représentent une convergence fascinante entre l’apprentissage automatique, le traitement d’image et l’ingénierie web. En s’appuyant sur des réseaux de neurones entraînés sur d’immenses bibliothèques visuelles, ils parviennent à recréer des détails plausibles là où il n’y avait que des pixels flous.

Bien qu’ils ne puissent pas vraiment “récupérer” l’information perdue, leur capacité à générer des améliorations visuellement convaincantes ouvre de nouvelles possibilités pour restaurer de vieilles photos, améliorer des images de surveillance ou simplement sauver cette photo de vacances un peu trop floue. Comme toute technologie puissante, elle s’accompagne de responsabilités, notamment concernant l’authenticité et l’usage éthique des images améliorées.